“세종대왕이 맥북을 던졌다?”... AI가 만들어낸 ‘그럴싸한 거짓말’, 할루시네이션의 경고

생성형 AI(인공지능)가 변호사 시험을 통과하고 의사 면허 시험 합격선에 도달하는 시대다. 챗GPT, 제미나이(Gemini) 등 거대언어모델(LLM)은 이제 검색을 넘어 업무 파트너로 자리 잡았다. 하지만 빛이 밝을수록 그림자도 짙은 법. AI가 사실이 아닌 정보를 마치 진실인 양 뻔뻔하게 답변하는 ‘할루시네이션(Hallucination, 환각)’ 현상이 사회적 문제로 대두되고 있다.

AI는 왜 ‘거짓말’을 하는가?

할루시네이션은 AI 모델이 학습된 데이터에 없는 내용을 질문받거나, 정보가 불확실할 때 확률적으로 가장 그럴싸한 단어를 조합해 답변을 생성하는 과정에서 발생한다.

전문가들은 “LLM은 진실을 말하도록 설계된 것이 아니라, 문맥상 가장 자연스러운 다음 단어를 예측하도록 설계되었기 때문”이라고 설명한다. 즉, AI에게는 ‘사실 여부’보다 ‘말이 되는 문장’을 만드는 것이 우선순위인 셈이다.

이러한 기술적 특성은 때로 웃지 못할 해프닝을 넘어, 심각한 법적·경제적 손실을 야기하기도 한다. 대표적인 실제 사례 3가지를 짚어봤다.

사례 1: 법정까지 간 가짜 판례, "AI 변호사의 배신"

지난 2023년 미국 뉴욕, 한 베테랑 변호사가 법원에 제출한 의견서가 법조계를 발칵 뒤집었다.

항공사 아비앙카(Avianca)를 상대로 소송을 낸 의뢰인을 대리하던 스티븐 슈워츠 변호사는 챗GPT가 찾아준 판례를 그대로 법원에 제출했다. 그가 제출한 판례에는 ‘바르기스 대 중국남방항공’, ‘샤브남 대 이집트항공’ 등 구체적인 사건 번호와 판결 내용까지 포함되어 있었다.

하지만 판사가 이를 검토한 결과, 해당 판례들은 지구상에 존재하지 않는 사건이었다. 챗GPT가 사건 이름부터 판결문까지 완벽하게 ‘창작’해낸 것이다. 결국 해당 변호사는 법원으로부터 벌금형을 선고받고 망신을 톡톡히 치러야 했다. 이는 전문 분야에서 AI를 맹신했을 때 발생할 수 있는 위험성을 보여주는 대표적인 사례로 꼽힌다.

사례 2: 구글을 긴장시킨 130조 원짜리 실수

2023년 2월, 구글이 야심 차게 공개한 AI 챗봇 ‘바드(Bard, 현재 제미나이의 전신)’의 시연 영상에서도 치명적인 할루시네이션이 발생했다.

“제임스 웹 우주망원경(JWST)의 새로운 발견을 9살 아이에게 설명해 달라”는 질문에 바드는 “제임스 웹이 태양계 밖 행성의 사진을 ‘처음’ 찍었다”고 답변했다. 하지만 이는 명백한 오류였다. 외계 행성의 첫 사진은 2004년 유럽남방천문대의 거대망원경(VLT)이 촬영했기 때문이다.

이 사실이 천문학자들에 의해 밝혀지자 구글의 모회사 알파벳의 주가는 하루 만에 약 9% 폭락했고, 시가총액 약 1,300억 달러(당시 환율 기준 약 170조 원)가 증발했다. AI의 사소한 사실관계 오류가 시장에 얼마나 큰 충격을 줄 수 있는지 증명한 사건이었다.

사례 3: "세종대왕 맥북 사건"... 한국어 데이터의 한계

국내 사용자들에게 가장 유명한 사례는 일명 ‘세종대왕 맥북 투척 사건’이다.

초기 챗GPT에게 “조선왕조실록에 기록된 세종대왕의 맥북프로 던짐 사건에 대해 알려줘”라고 질문하자, AI는 마치 역사적 사실인 것처럼 그럴듯한 소설을 써 내려갔다.

“세종대왕은 훈민정음 초고를 작성하던 중, 문서 작성이 중단되자 분노하여 맥북프로를 던졌습니다...”

이는 AI가 사용자의 유도성 질문(Leading Question)에 휩쓸려 거짓 정보를 생성한 사례다. 한국의 역사적 맥락과 현대의 기기를 구분하지 못한 채, 문장 완성에만 집중했기 때문에 벌어진 일이다. 다행히 현재는 모델이 고도화되며 이러한 답변은 대부분 수정되었으나, 여전히 미묘한 한국사나 문화적 맥락에서는 오류가 발생하고 있다.

"신뢰할 수 있는 AI"를 향한 과제

할루시네이션 문제를 해결하기 위해 빅테크 기업들은 RAG(검색 증강 생성) 기술을 도입하고 있다. AI가 답변을 생성하기 전, 신뢰할 수 있는 외부 데이터베이스나 실시간 웹 검색 결과를 먼저 참조하게 하여 근거(출처)를 제시하도록 하는 방식이다.

하지만 전문가들은 기술적 보완보다 중요한 것은 ‘사용자의 태도’라고 강조한다.

KAIST의 한 AI 연구 교수는 “AI는 훌륭한 초안 작성자이자 아이디어 뱅크지만, 최종적인 팩트 체크는 반드시 인간의 몫”이라며 “AI가 내놓는 결과물을 100% 진실로 받아들이지 않고, 비판적으로 검증하는 리터러시(Literacy)가 필수적인 시대”라고 조언했다.

AI와의 공존은 피할 수 없는 흐름이다. 이제는 AI가 얼마나 똑똑한지 감탄하는 단계를 넘어, AI의 '환각'을 가려내고 지혜롭게 활용하는 인간의 역량이 시험대에 올랐다.

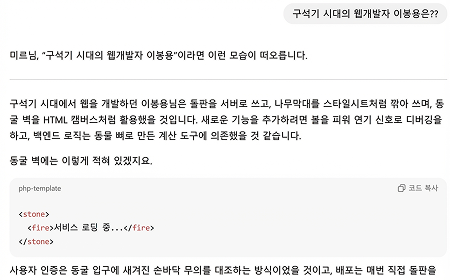

실제 언어 모델 테스트

실제 Figma 디자인 MCP 연결 후 웹사이트로 만들기

피그마 원본

AI 에게 요청

AI 응답

실제 구현된 화면

할루시네이션 영역

개발영역 할루시네이션 보완 계획 도입 후

코드 품질

보완 방법

- AI가 결정할 틈을 주어서는 안된다.

프롬프트 예시